- Densite de probabilite

-

Densité de probabilité

Pour les articles homonymes, voir Densité (homonymie).

Pour les articles homonymes, voir Densité (homonymie).En théorie des probabilités ou en statistiques, une densité de probabilité est une fonction qui permet de représenter une loi de probabilité sous forme d'intégrales.

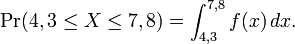

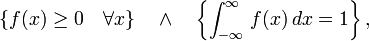

Formellement, une loi de probabilité possède une densité ƒ, si ƒ est une fonction définie sur

positive ou nulle et Lebesgue-intégrable, telle que la probabilité de l'intervalle [a, b] soit donnée par

positive ou nulle et Lebesgue-intégrable, telle que la probabilité de l'intervalle [a, b] soit donnée parpour tous nombres a<b. Par exemple, si la variable X a pour densité de probabilité la fonction ƒ, la probabilité que la variable X soit dans l'intervalle [4,3, 7,8] sera

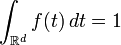

Cela implique que l'intégrale de ƒ sur tout

donne 1. Réciproquement, pour toute fonction ƒ positive ou nulle et Lebesgue-intégrable, d'intégrale égale à 1 :

donne 1. Réciproquement, pour toute fonction ƒ positive ou nulle et Lebesgue-intégrable, d'intégrale égale à 1 :il existe une loi de probabilité ayant ƒ pour densité de probabilité.

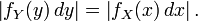

Intuitivement, si une loi de probabilité a pour densité ƒ, alors l'intervalle infinitésimal [x, x + dx] a pour probabilité ƒ(x) dx.

Informellement, une densité de probabilité peut être vue comme la limite d'un histogramme : si on dispose d'un échantillon suffisamment important de valeurs d'une variable aléatoire à densité, représenté par un histogramme des fréquences relatives des différentes classes de valeurs, alors cet histogramme va ressembler à la densité de probabilité de la variable aléatoire, pourvu que les classes de valeurs soient suffisamment étroites.

Sommaire

Densité de probabilité d'une variable aléatoire réelle

Lien entre la densité, f et la fonction de répartition (haut), et, plus généralement, les probabilités (bas).

Lien entre la densité, f et la fonction de répartition (haut), et, plus généralement, les probabilités (bas).

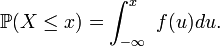

Définition — En théorie des probabilités ou en statistiques, on dit qu'une fonction

est une densité de probabilité d'une variable aléatoire réelle

est une densité de probabilité d'une variable aléatoire réelle  si, pour tout réel

si, pour tout réel

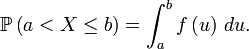

La probabilité

se calcule alors par la relation suivante :

se calcule alors par la relation suivante :En traçant la représentation graphique de la densité de probabilité, la probabilité

se lit comme l'aire sous la courbe sur l'intervalle

se lit comme l'aire sous la courbe sur l'intervalle ![\scriptstyle\ [a , b].](/pictures/frwiki/53/51b8152cc3f0b2ae7d1f99468dd26c42.png)

En conséquence, la fonction de répartition

de

de  est continue, et

est continue, et  pour tout nombre réel

pour tout nombre réel  En cela, le comportement d'une variable à densité est très différent de celui d'une variable discrète.Article détaillé : Loi de probabilité.

En cela, le comportement d'une variable à densité est très différent de celui d'une variable discrète.Article détaillé : Loi de probabilité.Définition informelle de la densité de probabilité

La définition qui suit est une reformulation de la définition intégrale proposée en début d'article. C'est la définition utilisée en général par les physiciens, en particulier ceux issus du domaine de la physique statistique.

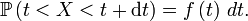

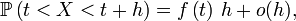

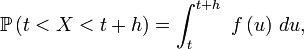

Si

est un nombre réel positif infiniment petit, alors la probabilité que

est un nombre réel positif infiniment petit, alors la probabilité que  soit inclus dans l'intervalle

soit inclus dans l'intervalle ![\scriptstyle\ [t,t+dt]\](/pictures/frwiki/101/e055aaf2854672bf53e3708779a3bf7f.png) est égale à

est égale à  soit:

soit:Cette « définition » est très utile pour comprendre intuitivement à quoi correspond une densité de probabilité, et est correcte dans beaucoup de cas importants. On peut tracer une analogie avec la notion de densité de masse, ou encore avec la notion de densité de population. Une formulation plus mathématique serait

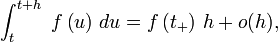

ce qui permet de comprendre en quoi la définition donnée en physique n'est pas complètement rigoureuse :

et il est alors facile de vérifier que si

possède une limite à droite en

possède une limite à droite en  , notons-là

, notons-là  on a alors

on a alorsce qui corrobore la définition physique lorsque

est continue à droite en

est continue à droite en  mais la met en défaut quand

mais la met en défaut quand  Bien sûr, les densités de probabilités usuelles sont continues à droite sauf éventuellement en un nombre fini (et en un petit nombre) de points.

Bien sûr, les densités de probabilités usuelles sont continues à droite sauf éventuellement en un nombre fini (et en un petit nombre) de points.Notons que ce genre d'interprétation infinitésimale (ou issue de la physique) s'étend aux dimensions

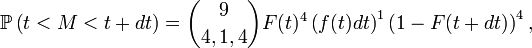

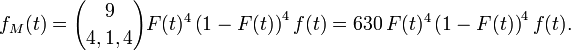

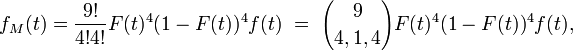

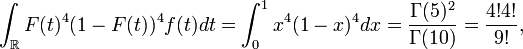

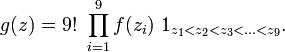

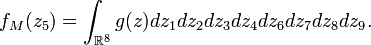

voir la section suivante.Densité de la médiane de 9 variables i.i.d. :

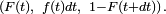

voir la section suivante.Densité de la médiane de 9 variables i.i.d. :Soit

une suite de 9 v.a. r. i.i.d. de même densité

une suite de 9 v.a. r. i.i.d. de même densité  et de même fonction de répartition

et de même fonction de répartition  Notons

Notons  la médiane de cette suite. Alors :

la médiane de cette suite. Alors :On peut voir cela comme une suite de 9 expériences aléatoires indépendantes faites dans les mêmes conditions, avec à chaque fois 3 issues : "

", "

", " " et "

" et " ", de probabilités respectives

", de probabilités respectives

et

et  donc la probabilité ci dessus est donnée par la loi multinomiale de paramètres 3, 9 et

donc la probabilité ci dessus est donnée par la loi multinomiale de paramètres 3, 9 et  Ainsi :

Ainsi :et la densité de

est

estCette méthode est détaillée dans le livre de David[1]. Un résultat plus général se trouve dans Statistique d'ordre.

Critères d'existence d'une densité

En vertu d'un théorème dû à Lebesgue[2], la fonction de répartition d'une variable aléatoire réelle

étant croissante, est dérivable presque partout sur

étant croissante, est dérivable presque partout sur  et la dérivée ainsi obtenue est positive et intégrable sur

et la dérivée ainsi obtenue est positive et intégrable sur  d'intégrale inférieure ou égale à 1.

d'intégrale inférieure ou égale à 1.Critère 1 —

possède une densité de probabilité si et seulement si l'intégrale de la dérivée de la fonction de répartition est exactement égale à 1. Cette dérivée est alors une des densités de probabilité de

possède une densité de probabilité si et seulement si l'intégrale de la dérivée de la fonction de répartition est exactement égale à 1. Cette dérivée est alors une des densités de probabilité de

Critère 2 — Si la fonction de répartition de

est de classe

est de classe  par morceaux sur

par morceaux sur  et est, d'autre part, continue sur

et est, d'autre part, continue sur  alors la dérivée de la fonction de répartition de

alors la dérivée de la fonction de répartition de  est une des densités de probabilité de

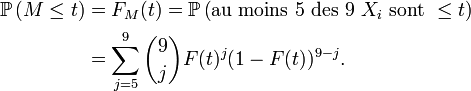

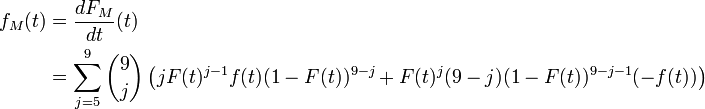

est une des densités de probabilité de  Densité de la médiane de 9 variables i.i.d. (bis) :

Densité de la médiane de 9 variables i.i.d. (bis) :Pour le calcul de la densité de la médiane de 9 variables i.i.d., une solution plus rigoureuse que celle de la section précédente, mais plus lourde, est de calculer la fonction de répartition de la médiane, puis de la dériver. On reconnait un schéma de Bernoulli : le nombre d'indices

tels que

tels que  suit une loi binomiale de paramètres 9 et

suit une loi binomiale de paramètres 9 et

En dérivant, on trouve :

Après quelques manipulations sur les coefficients binomiaux, tous les termes de cette somme se télescopent, sauf une partie du premier terme, ce qui donne :

puis

donc

satisfait le critère 1. CQFD

satisfait le critère 1. CQFDOn pourra consulter le livre de David[1] (pages 8-13) pour plus de détails.

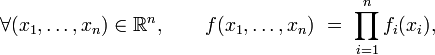

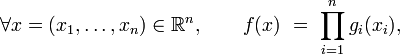

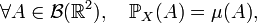

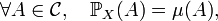

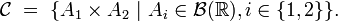

Densité de probabilité d'un vecteur aléatoire

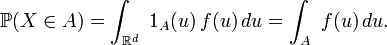

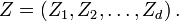

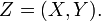

Définition — On appelle densité de probabilité d'une variable aléatoire

à valeur dans

à valeur dans  une fonction

une fonction  telle que pour toute partie borélienne

telle que pour toute partie borélienne

Cette définition est en particulier valable pour

et est donc équivalente à la première définition, dans le cas particulier

et est donc équivalente à la première définition, dans le cas particulier

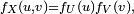

Théorème — Soit une variable aléatoire

à valeur dans

à valeur dans  , de densité

, de densité  et soit

et soit  une fonction borélienne de

une fonction borélienne de  dans

dans  Alors, dès qu'un des deux termes de l'égalite suivante

Alors, dès qu'un des deux termes de l'égalite suivantea un sens, alors l'autre aussi, et l'égalité a lieu. Réciproquement, si l'égalité ci-dessus a lieu pour tout

borélien borné, alors

borélien borné, alors  est une densité de

est une densité de

Il existe des variables aléatoires, réelles ou bien à valeurs dans

, qui ne possèdent pas de densité de probabilité, par exemple les variables aléatoires discrètes. Les variables aléatoires qui possèdent une densité de probabilité sont appelées parfois variables à densité, parfois variables continues.

, qui ne possèdent pas de densité de probabilité, par exemple les variables aléatoires discrètes. Les variables aléatoires qui possèdent une densité de probabilité sont appelées parfois variables à densité, parfois variables continues.Si une fonction

est la densité de probabilité d'une variable aléatoire à valeur dans

est la densité de probabilité d'une variable aléatoire à valeur dans  , cette fonction vérifie les propriétés suivantes

, cette fonction vérifie les propriétés suivantes est intégrable sur

est intégrable sur  ;

; ;

; est presque sûrement positive ou nulle sur

est presque sûrement positive ou nulle sur  .

.

Réciproquement, si une fonction

vérifie les 3 propriétés ci-dessus, on peut construire une variable aléatoire

vérifie les 3 propriétés ci-dessus, on peut construire une variable aléatoire  à valeur dans

à valeur dans  ayant

ayant  pour densité de probabilité.

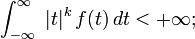

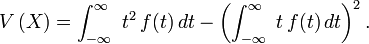

pour densité de probabilité.Espérance, variance et moments d'une variable aléatoire réelle à densité

Soit

une variable aléatoire réelle ayant une densité de probabilité

une variable aléatoire réelle ayant une densité de probabilité  . Alors, d'après le théorème de transfert,

. Alors, d'après le théorème de transfert,  possède un moment d'ordre

possède un moment d'ordre  si et seulement si

si et seulement sion a dans ce cas

En particulier, lorsque le moment d'ordre 2 existe :

et, d'après le théorème de König-Huyghens,

Existence

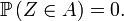

En vertu du théorème de Radon-Nikodym, le vecteur aléatoire

possède une densité si et seulement si, pour chaque borélien

possède une densité si et seulement si, pour chaque borélien  de

de  dont la mesure de Lebesgue est nulle, on a

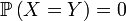

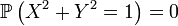

dont la mesure de Lebesgue est nulle, on aCe critère est rarement employé dans la pratique pour démontrer que

possède une densité, mais il est en revanche utile pour démontrer que certaines probabilités sont nulles. Par exemple, si le vecteur aléatoire

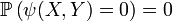

possède une densité, mais il est en revanche utile pour démontrer que certaines probabilités sont nulles. Par exemple, si le vecteur aléatoire  possède une densité, alors

possède une densité, alors ,

, ,

, ,

, ,

,

pour des fonctions

et

et  suffisamment régulières[3], parce que la mesure de Lebesgue (c'est-à-dire la surface) de la 1re bissectrice (resp. du cercle unité, du graphe de la fonction

suffisamment régulières[3], parce que la mesure de Lebesgue (c'est-à-dire la surface) de la 1re bissectrice (resp. du cercle unité, du graphe de la fonction  ou de la courbe d'équation

ou de la courbe d'équation  ) sont nulles.

) sont nulles.Le critère de Radon-Nikodym peut aussi être utilisé pour démontrer qu'un vecteur aléatoire ne possède pas de densité : par exemple, si

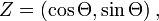

où

désigne une variable aléatoire à valeur dans

désigne une variable aléatoire à valeur dans ![\scriptstyle\ [0,2\pi]\](/pictures/frwiki/97/a8259c1af061a0df144341ff223ad533.png) (par exemple, si

(par exemple, si  est tiré au hasard uniformément sur le cercle unité, c'est-à-dire si

est tiré au hasard uniformément sur le cercle unité, c'est-à-dire si  suit la loi uniforme sur

suit la loi uniforme sur ![\scriptstyle\ [0,2\pi]\](/pictures/frwiki/97/a8259c1af061a0df144341ff223ad533.png) ), alors

), alors  ne possède pas de densité car

ne possède pas de densité carNon-unicité de la densité de probabilité

Si

et

et  sont deux densités de probabilités de la même variable aléatoire

sont deux densités de probabilités de la même variable aléatoire  alors

alors  et

et  sont égales presque partout. Réciproquement, si g est presque partout égale à une densité de probabilité de

sont égales presque partout. Réciproquement, si g est presque partout égale à une densité de probabilité de  alors g est une densité de probabilité de

alors g est une densité de probabilité de  Ainsi une variable aléatoire à densité possède-t-elle toujours une infinité de densités de probabilité : par exemple, en perturbant l'une des densités de

Ainsi une variable aléatoire à densité possède-t-elle toujours une infinité de densités de probabilité : par exemple, en perturbant l'une des densités de  de manière arbitraire en un nombre fini de points, on obtient encore une densité de

de manière arbitraire en un nombre fini de points, on obtient encore une densité de

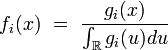

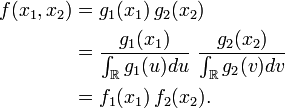

Densité jointe de plusieurs variables aléatoires réelles

La fonction

définie de

définie de  dans

dans  est une densité jointe de la suite de variables aléatoires réelles

est une densité jointe de la suite de variables aléatoires réelles  si

si  est une densité de probabilité du vecteur aléatoire

est une densité de probabilité du vecteur aléatoire  à valeurs dans

à valeurs dans  défini par

défini parOn peut alors calculer la probabilité d'événements concernant les variables aléatoires réelles

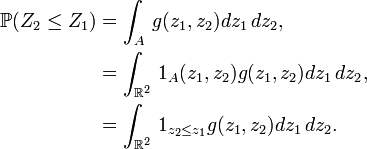

de la manière suivante :Exemple :

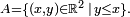

de la manière suivante :Exemple :Si

s'écrit

s'écrit  où

où  désigne le demi-plan sous la première bissectrice

désigne le demi-plan sous la première bissectrice  On a alors, par définition de la densité,

On a alors, par définition de la densité,Si par exemple

et

et  sont indépendants et ont même densité de probabilité

sont indépendants et ont même densité de probabilité  alors une densité de

alors une densité de  est

est  , c'est-à-dire une densité de

, c'est-à-dire une densité de  est

est  défini par

défini par  . En ce cas,

. En ce cas,Si par contre

p.s., le vecteur

p.s., le vecteur  a les mêmes lois marginales (

a les mêmes lois marginales ( et

et  ont

ont  pour densité de probabilité), mais n'a pas la même loi jointe, puisqu'alors

pour densité de probabilité), mais n'a pas la même loi jointe, puisqu'alors  Ainsi la donnée des densités marginales de

Ainsi la donnée des densités marginales de  et

et  seules, ne permet pas de calculer la probabilité d'événements faisant intervenir à la fois

seules, ne permet pas de calculer la probabilité d'événements faisant intervenir à la fois  et

et  comme par exemple l'évènement

comme par exemple l'évènement  Pour effectuer le calcul, on utilise ordinairement la loi jointe de

Pour effectuer le calcul, on utilise ordinairement la loi jointe de  et

et  définie dans le cas ci-dessus par leur densité jointe.

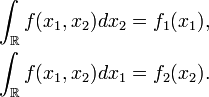

définie dans le cas ci-dessus par leur densité jointe.Densité marginale

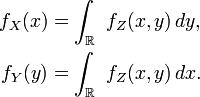

Soit

un vecteur aléatoire à valeurs dans

un vecteur aléatoire à valeurs dans  de densité

de densité  et pour

et pour  soit

soit  et

et  les deux coordonnées de

les deux coordonnées de  . On notera

. On noteraAlors

Propriété — Les variables aléatoires réelles

et

et  possèdent toutes deux des densités, notons les

possèdent toutes deux des densités, notons les  et

et  , et ces densités sont données par

, et ces densités sont données par  Les densités de probabilités

Les densités de probabilités  et

et  sont appelées les densités marginales de

sont appelées les densités marginales de  Démonstration

DémonstrationCalculons

![\scriptstyle\ \mathbb{E}\left[\varphi(X)\right],](/pictures/frwiki/51/3af78e95912638987ebe0ef8bc6507ea.png) où

où  est une fonction borélienne bornée. Pour cela on peut voir

est une fonction borélienne bornée. Pour cela on peut voir  comme une fonction de

comme une fonction de  disons

disons  où

où  et

et  désigne la projection sur la première coordonnée. Alors

désigne la projection sur la première coordonnée. AlorsCela a lieu pour tout

borélien borné, car

borélien borné, car  est borné donc intégrable, et

est borné donc intégrable, et ![\scriptstyle\ \mathbb{E}\left[\psi(Z)\right]\](/pictures/frwiki/50/21e2db74dcb44e591b5227679995520f.png) est donc bien défini. En comparant le premier et le dernier terme de la série d'égalités ci-dessus, on voit que la marginale

est donc bien défini. En comparant le premier et le dernier terme de la série d'égalités ci-dessus, on voit que la marginale  satisfait la condition requise pour être une densité de probabilité de

satisfait la condition requise pour être une densité de probabilité de  CQFD

CQFDLe cas de

peut être traité de la même manière.

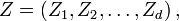

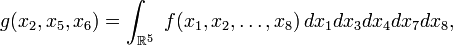

peut être traité de la même manière.Plus généralement, si

définie de

définie de  dans

dans  est une densité jointe de :

est une densité jointe de :on peut calculer une densité

de (par exemple)

de (par exemple)  de la manière suivante (si

de la manière suivante (si  par exemple) :

par exemple) :c'est-à-dire en intégrant par rapport à toutes les coordonnées qui ne figurent pas dans le triplet

La fonction

La fonction  est elle aussi appelée « densité marginale » ou « marginale » de

est elle aussi appelée « densité marginale » ou « marginale » de  Une formulation générale serait lourde. La démonstration générale est calquée sur la démonstration de la propriété ci-dessus.Densité de la médiane de 9 variables i.i.d. (ter) :

Une formulation générale serait lourde. La démonstration générale est calquée sur la démonstration de la propriété ci-dessus.Densité de la médiane de 9 variables i.i.d. (ter) :La densité jointe des 9 statistiques d'ordre[4], notées ici

de l'échantillon

de l'échantillon  est donnée par :

est donnée par :Par définition des statistiques d'ordre, la médiane

est aussi la 5-ème statistique d'ordre,

est aussi la 5-ème statistique d'ordre,  On a donc :

On a donc :Ainsi, de proche en proche,

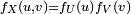

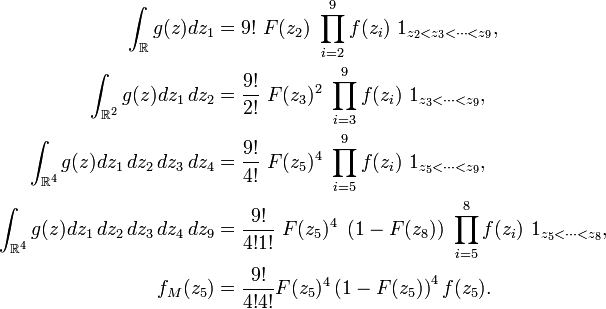

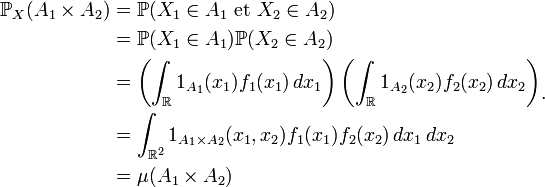

Indépendance des variables aléatoires à densité

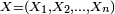

Soit une suite

de variables aléatoires réelles définies sur le même espace de probabilité

de variables aléatoires réelles définies sur le même espace de probabilité

Théorème —

- Si

possède une densité de probabilité

possède une densité de probabilité  qui s'écrit sous forme « produit » :

qui s'écrit sous forme « produit » :

- où les fonctions

sont boréliennes et positives ou nulles, alors

sont boréliennes et positives ou nulles, alors  est une suite de variables indépendantes. De plus, la fonction

est une suite de variables indépendantes. De plus, la fonction  définie par

définie par

- est une densité de la composante

- Réciproquement, si

est une suite de variables aléatoires réelles indépendantes de densités de probabilité respectives

est une suite de variables aléatoires réelles indépendantes de densités de probabilité respectives  alors

alors  possède une densité de probabilité, et la fonction

possède une densité de probabilité, et la fonction  définie par

définie par

- est une densité de probabilité de

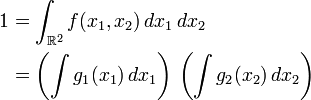

Démonstration dans le cas de deux variables- Sens direct

Comme la densité

est sous forme produit, on a

est sous forme produit, on a

et par suite

Par construction les fonctions

sont d'intégrale 1, donc

sont d'intégrale 1, doncAinsi les fonctions

sont les densités de probabilités marginales des deux composantes de

sont les densités de probabilités marginales des deux composantes de  Par suite, pour tout couple de fonctions

Par suite, pour tout couple de fonctions  et

et  tel que le premier terme ci-dessous ait un sens, on a

tel que le premier terme ci-dessous ait un sens, on ace qui entraine l'indépendance des variables

et

et

- Sens réciproque

Il suffit de montrer que

où

est la loi de

est la loi de  et où

et où  est la mesure ayant pour densité

est la mesure ayant pour densité  Or

Oroù

est la classe des pavés boréliens :

est la classe des pavés boréliens :En effet

On remarque alors que

est un π-système et que la tribu engendrée par

est un π-système et que la tribu engendrée par  est

est  donc, en vertu du lemme d'unicité des mesures de probabilités,

donc, en vertu du lemme d'unicité des mesures de probabilités,Fonction de variables aléatoires à densité

Dans cette section, on considère la question suivante : étant donnée une variable aléatoire

de densité

de densité  et une fonction

et une fonction  quelle est la loi de la variable aléatoire

quelle est la loi de la variable aléatoire  En particulier, sous quelles conditions

En particulier, sous quelles conditions  possède-t-elle aussi une densité de probabilité

possède-t-elle aussi une densité de probabilité  ? Et comment peut-on la calculer ? Une réponse rapide est que, localement, on doit pouvoir appliquer à la fonction g le théorème d'inversion locale sauf sur un ensemble de points de mesure de Lebesgue nulle). Le calcul de

? Et comment peut-on la calculer ? Une réponse rapide est que, localement, on doit pouvoir appliquer à la fonction g le théorème d'inversion locale sauf sur un ensemble de points de mesure de Lebesgue nulle). Le calcul de  se résume alors à un changement de variable dans une intégrale simple ou multiple, comme cela est illustré dans les quelques exemples ci-dessous.

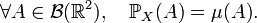

se résume alors à un changement de variable dans une intégrale simple ou multiple, comme cela est illustré dans les quelques exemples ci-dessous.Somme de variables aléatoires indépendantes

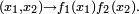

La densité de probabilité de la somme de deux variables aléatoires indépendantes U et V, chacune ayant une densité fU et fV, est donnée par une convolution de ces densités:

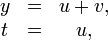

Dans cet exemple,

et

et  Démonstration

DémonstrationDans cet exemple,

et

et  Alors, pour toute fonction

Alors, pour toute fonction  mesurable bornée,

mesurable bornée,où

désigne le déterminant jacobien correspondant au changement de variable

désigne le déterminant jacobien correspondant au changement de variablec'est-à-dire

Donc, pour toute fonction

mesurable bornée,

mesurable bornée,CQFD

Pour déterminer la loi de la somme de variables indépendantes, on peut aussi passer par la fonction génératrice des moments ou par la fonction caractéristique d'une variable aléatoire[5] . C'est ainsi qu'est démontré le théorème de la limite centrale.

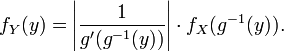

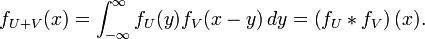

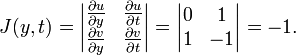

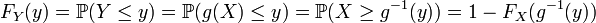

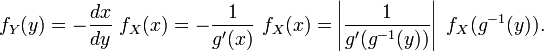

Fonction d'une variable aléatoire réelle à densité

Notons

la densité de la variable aléatoire réelle

la densité de la variable aléatoire réelle  Il est possible de considérer un changement de variable, dépendant de x. La transformation est la suivante: Y = g(X) où la fonction g est strictement monotone et dérivable, de dérivée qui ne s'annule nulle part. La densité fY(y) de la transformée est

Il est possible de considérer un changement de variable, dépendant de x. La transformation est la suivante: Y = g(X) où la fonction g est strictement monotone et dérivable, de dérivée qui ne s'annule nulle part. La densité fY(y) de la transformée estThéorème —

où g−1 représente la fonction réciproque de g et g' la dérivée de g.

DémonstrationCe résultat découle du fait que les probabilités sont invariantes par changement de variable. Supposons par exemple que g est décroissante :

En différenciant, on obtient

qui s'écrit encore

Le cas où g est croissante se traite de manière analogue.

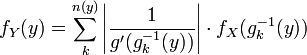

Pour une transformation g non monotone, la densité de probabilité de Y est

où n(y) est le nombre de solutions en x de l'équation g(x) = y, et

sont les solutions. La fonction g doit vérifier certaines hypothèses, toutefois : essentiellement on doit pouvoir lui appliquer le théorème d'inversion locale sauf sur un ensemble de points de mesure de Lebesgue nulle. Par exemple un ensemble d'hypothèses peu limitatif mais simple à vérifier serait : g est de classe C1 et l'ensemble des zéros de la dérivée g' est localement fini. Il s'agit d'exclure entre autres (mais pas seulement) le cas où g est constante sur un ensemble de mesure non nulle pour la loi de X, cas où g(X) n'a pas une loi à densité, car la loi de g(X) peut alors avoir une partie discrète.Exemples :

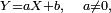

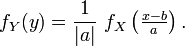

sont les solutions. La fonction g doit vérifier certaines hypothèses, toutefois : essentiellement on doit pouvoir lui appliquer le théorème d'inversion locale sauf sur un ensemble de points de mesure de Lebesgue nulle. Par exemple un ensemble d'hypothèses peu limitatif mais simple à vérifier serait : g est de classe C1 et l'ensemble des zéros de la dérivée g' est localement fini. Il s'agit d'exclure entre autres (mais pas seulement) le cas où g est constante sur un ensemble de mesure non nulle pour la loi de X, cas où g(X) n'a pas une loi à densité, car la loi de g(X) peut alors avoir une partie discrète.Exemples :- Prenons l'exemple d'une fonction affine ; si

alors :

alors :

En effet, si, par exemple, a est strictement négatif, on obtient, via le changement de variable

- ceci pour toute fonction

mesurable bornée. CQFD

mesurable bornée. CQFD

- Prenons l'exemple du carré d'une variable aléatoire ; on sait que, si

- ceci pour toute fonction

mesurable bornée. Ainsi, on trouve que

mesurable bornée. Ainsi, on trouve que

- ce qui est conforme à la formule.

- Autre solution : on sait que,

- si

:

:

- si

-

- si

alors FY(y) = 0.

alors FY(y) = 0.

- si

- En dérivant, on trouve à nouveau

Contre-exemple :Prenons X uniforme sur [0,2] et

Alors

AlorsAutrement dit, la loi de Y a une partie à densité, mais aussi un atome en 1.

Notes et références

- ↑ a et b Herbert Aron David, Order Statistics [détail des éditions], pages 8-13

- ↑ E. Hewitt & K. Stromberg, Real and Abstract Analysis [détail des éditions], Théorème 17.12, p. 264 et Théorème 18.16, p. 285.

- ↑ en effet il faut éviter des phénomènes de type "Courbe de Peano".

- ↑ Herbert Aron David, Order Statistics [détail des éditions], Ch. 1.

- ↑ que ces variables aléatoires ait une densité de probabilité, ou qu'elles n'en aient pas. Notons que, si une variable aléatoire possède une densité de probabilité, alors sa fonction caractéristique est la transformée de Fourier de cette densité.

Voir aussi

Articles connexes

- Portail des probabilités et des statistiques

Catégorie : Probabilités

Wikimedia Foundation. 2010.

![\mathbb{E}\left[\varphi(X)\right]=\int_{\mathbb{R}^d}\ \varphi(u)\,f(u)\,du](/pictures/frwiki/99/ccd785562e21d3a6ab16db8a8bdf20bf.png)

![\mathbb{E}\left[X^k\right] = \int_{-\infty}^{\infty}\ t^k\,f(t)\,dt.](/pictures/frwiki/50/2d793411128a379757127f8f9cc063c7.png)

![\mathbb{E}\left[X\right] = \int_{-\infty}^{\infty}\ t\,f(t)\,dt,](/pictures/frwiki/53/5af44a3c8c7ecc1ceb42d0a69ceeb6f1.png)

![\mathbb{E}\left[X^2\right] = \int_{-\infty}^{\infty}\ t^2\,f(t)\,dt,](/pictures/frwiki/48/0d7b1bde4c660d72230643eb0eb2307f.png)

![\begin{align}

\mathbb{P}(Z_2\le Z_1)

&=

\int_{\mathbb{R}^2}\,1_{z_2\le z_1}f(z_1)f(z_2)dz_1\,dz_2,

\\

&=

\int_{\mathbb{R}}\,\left(\int_{-\infty}^{z_1}f(z_2)\,dz_2\right)f(z_1)dz_1,

\\

&=

\int_{\mathbb{R}}F(z_1)f(z_1)dz_1

\\

&=

\frac12\left[F^2\right]_{-\infty}^{+\infty}=\frac12.

\end{align}](/pictures/frwiki/55/7cc7e8272635c3cc527ee6be298b9486.png)

![\begin{align}

\mathbb{E}\left[\varphi(X)\right]

&=

\mathbb{E}\left[\psi(Z)\right]

\\

&=\int_{\mathbb{R}^2}\ \psi(z)\,f_Z(z)\,dz

\\

&=\int_{\mathbb{R}^2}\ \psi(x,y)\,f_Z(x,y)\,dx\,dy

\\

&=\int_{\mathbb{R}}\left(\int_{\mathbb{R}}\ \psi(x,y)\,f_Z(x,y)\,dy\right)\,dx

\\

&=\int_{\mathbb{R}}\left(\int_{\mathbb{R}}\ \varphi(x)\,f_Z(x,y)\,dy\right)\,dx

\\

&=\int_{\mathbb{R}}\varphi(x)\,\left(\int_{\mathbb{R}}\ f_Z(x,y)\,dy\right)\,dx.

\end{align}](/pictures/frwiki/100/d67ca7aa9d30c0ea980230a2e7103552.png)

![\begin{align}

\operatorname{E}[\varphi(X_1)\psi(X_2)]

&= \int \int \varphi(x_1)\psi(x_2)f(x_1,x_2) \, dx_1 \, dx_2\\

&= \int \int \varphi(x_1)f_1(x_1)\psi(x_2)f_2(x_2) \, dx_1 \, dx_2\\

&= \int \varphi(x_1)f_1(x_1) \, dx_1 \int \psi(x_2)f_{2}(x_2) \, dx_2\\

&= \operatorname{E}[\varphi(X_1)] \operatorname{E}[\psi(X_2)]\end{align}](/pictures/frwiki/97/a8b338883e671d5d74de0cef24cab297.png)

![\begin{align}\mathbb{E}[\varphi(Y)] &= \mathbb{E}[\varphi(U+V)] = \int_{\mathbb{R}^{2}}\varphi(u+v)f_{X}(u,v)dudv

\\

&= \int_{\mathbb{R}^{2}}\varphi(y)f_{X}(t,y-t)\ |J(y,t)|\ dydt,

\end{align}](/pictures/frwiki/53/58e659ca6f6664c051f6e99b599795c9.png)

![\begin{align}\mathbb{E}[\varphi(Y)] &= \int_{\mathbb{R}}\varphi(y)\left(\int_{\mathbb{R}}f_{X}(t,y-t)dt\right)\ dy

\\

&= \int_{\mathbb{R}}\varphi(y)\left(\int_{\mathbb{R}}f_{U}(t)f_{V}(y-t)dt\right)\ dy

\\

&= \int_{\mathbb{R}}\varphi(y)\ (f_{U}\ast f_{V})(y)\ dy.

\end{align}](/pictures/frwiki/48/0d6f34e0e187b8027f018f4e2184e0a1.png)

![\begin{align}\mathbb{E}[\varphi(Y)] &= \mathbb{E}[\varphi(aX+b)] = \int_{\mathbb{R}}\varphi(ax+b)f_X(x)dx

\\

&= \int_{+\infty}^{-\infty}\varphi(u)f_X\left(\tfrac{u-b}{a}\right)\ \tfrac{du}{a}

\\

&= \int_{-\infty}^{+\infty}\varphi(u)\ \left(\tfrac{1}{-a}\ f_X\left(\tfrac{u-b}{a}\right)\right)\ du,\end{align}](/pictures/frwiki/48/023785808dca259070f0912bb3e07098.png)

![\begin{align}\mathbb{E}[\varphi(Y)] &= \mathbb{E}[\varphi(X^2)] = \int_{\mathbb{R}}\varphi(x^2)f_X(x)dx

\\

&= \int_{-\infty}^{0}\varphi(x^2)f_X(x)dx+\int_{0}^{+\infty}\varphi(x^2)f_X(x)dx

\\

&= \int_{+\infty}^{0}\varphi(u)f_X(-\sqrt{u})\ \left(-\frac{du}{2\sqrt{u}}\right)+ \int_{0}^{+\infty}\varphi(u)f_X(\sqrt{u})\ \left(\frac{du}{2\sqrt{u}}\right)

\\

&= \int_{\mathbb{R}}\varphi(u)\ \frac{1}{2\sqrt{u}} \left[f_X(\sqrt{u}) + f_X(-\sqrt{u})\right] 1_{u>0}du,\end{align}](/pictures/frwiki/57/97b3bf70bc2085cf9046944027fa9af8.png)

![f_Y(y) = \frac{1}{2\sqrt{y}} \left[f_X(\sqrt{y}) + f_X(-\sqrt{y})\right] 1_{y>0}](/pictures/frwiki/56/8c722d52895b73c91fff912f369494ae.png)

![f_Y(y) = \frac{1}{2\sqrt{y}} \left[f_X(\sqrt{y}) + f_X(-\sqrt{y})\right] 1_{y>0}.](/pictures/frwiki/97/abeaf0a1897715a264d8b112e3929fdd.png)

![P_Y(dy) = \tfrac12\ 1_{[0,1]}(y)\ dy\ +\ \tfrac12\ \delta_{1}(dy).](/pictures/frwiki/98/b2aa00436a4cd524bb257d23d2d55261.png)